@语义透明度对德语复合词的影响Semantic transparency effects in German compoundsA large dataset and multiple-task investigation

Semantic transparency effects in German compoundsA large dataset and multiple-task investigation

摘要

- 核心贡献: 为1810个德语复合词提供了全面的、多维度的语义透明度量化数据集,并通过四个不同的行为实验进行验证。

- 核心发现: 不同的语义效应在不同的认知任务中出现。这表明,理解复合词加工必须采用多维度的语义透明度模型,特别是要区分组合性 (compositionality) 和关联性 (relatedness)。

核心概念与研究视角

- 语义透明度 (Semantic Transparency): 衡量复合词的整体意义在多大程度上可以从其构成成分的意义中清晰推断。

- 高透明度: airport (机场)

- 低透明度: strawberry (草莓), sandman (睡魔)

- 两种核心视角:

- 关联性视角 (Relatedness-based)

- 概念: 将复合词及其成分视为语义记忆中独立的单元。

- 衡量: 它们之间的关联激活强度。

- 组合性视角 (Compositional-based)

- 概念: 将成分视为构建复合词意义的**“积木”**,强调主动的组合过程。

- 衡量: 成分对组合过程的贡献度和复合词意义的可预测性。

- 关联性视角 (Relatedness-based)

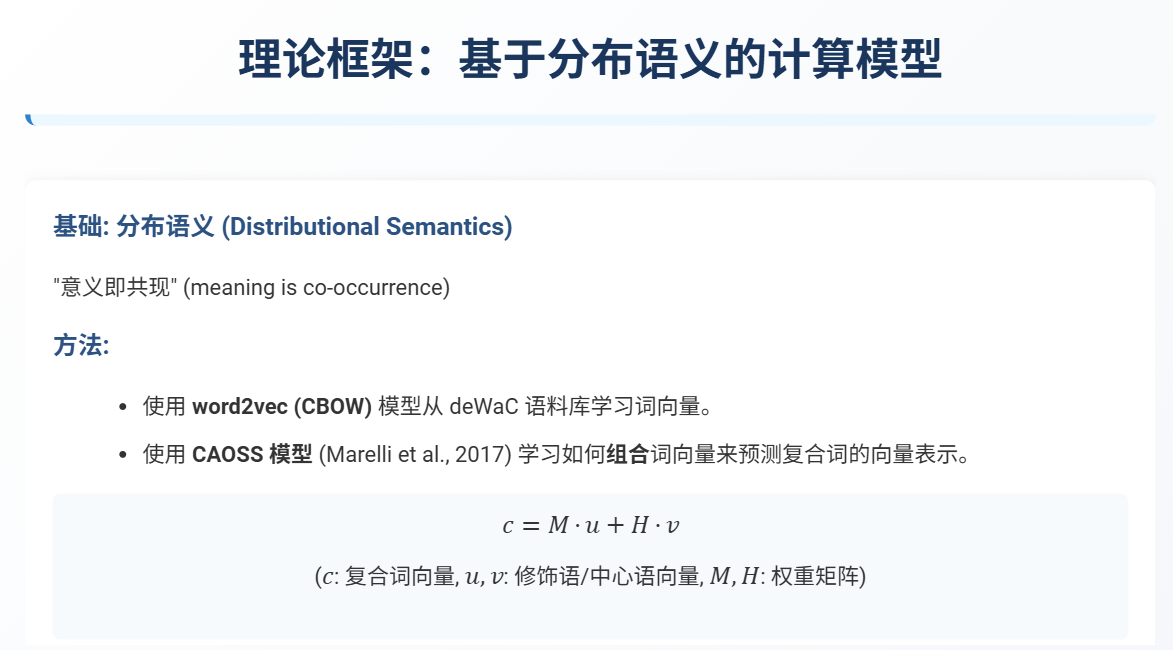

计算模型与测量维度

- 模型基础: 基于大型语料库的分布式语义模型 (distributional semantics),具体为

word2vec。 - 六个关键测量维度:

- 关联性 (Relatedness) 维度:

- 修饰语关联性 (Modifier Relatedness): 修饰语 ↔ 整个复合词

- 核心词关联性 (Head Relatedness): 核心词 ↔ 整个复合词

- 成分相似性 (Constituent Similarity): 修饰语 ↔ 核心词

- 组合性 (Compositionality) 维度:

- 修饰语组合性 (Modifier Composition): 修饰语 → 组合后的意义

- 核心词组合性 (Head Composition): 核心词 → 组合后的意义

- 复合词组合性 (Compound Compositionality): 组合意义 ↔ 整个复合词 (即意义的可预测性)

- 关联性 (Relatedness) 维度:

实验验证与核心发现

核心洞见: 语义透明度的影响表现出显著的任务依赖性 (task-dependency)。

-

1. 显性评分任务 (Explicit Ratings)

- 任务: 被试直接对复合词的透明度进行评分。

- 发现: 评分结果同时受到组合性和关联性两种因素的影响。这表明人类对透明度的直觉判断是多个语义维度的混合体。

-

2. 词汇判断任务 (Lexical Decision Tasks)

- 任务: 快速判断屏幕上出现的字符串是否是一个真实的德语单词。

- 发现:

- 反应时只受组合性指标预测 (特别是

修饰语组合性),而不受关联性指标影响。 - 结论: 复合词加工涉及一个自动的、强制性的组合过程 (automatic, obligatory compositional process),该过程在词汇通达的早期阶段起作用。

- 对于由真实单词构成的新造词 (如 Knotenpferd, 节马),

修饰语组合性越高,被试越难拒绝,反应时变慢。

- 反应时只受组合性指标预测 (特别是

-

3. 眼动追踪任务 (Eye-Tracking during reading)

- 任务: 在阅读理解过程中加工复合词。

- 发现:

- 注视时间只受关联性指标预测,而不受组合性指标影响。

核心词关联性高 → 促进加工 ( gaze duration 缩短),因为核心词定义了复合词的语义类别,有助于理解。修饰语关联性高 → 抑制加工 ( first fixation duration 延长),可能源于修饰语的独立意义与复合词的整体意义之间存在激活竞争。

理论启示与总结

- 任务分离假说:

- 快速词汇通达任务 (Lexical Access): 由组合过程主导。加工更侧重于“这个词是如何构成的”。

- 完整意义理解任务 (Meaning Comprehension): 由与词汇化意义的关联性主导。加工更侧重于“这个词的实际意思是什么”。

- 重要意义:

- 该研究通过清晰的实验证据,解释了以往文献中关于语义透明度效应的矛盾和不一致——这些不一致源于不同研究所采用的实验范式不同。

- 为未来的复合词研究提供了关键的理论框架和大型数据集,强调了将语义透明度视为多维结构的重要性。

问答

文中的相关性和组合性,有什么区别,是怎么计算出来的?另外 CAOSS 模型的权重是怎么学习的?

好的,我们来详细解析这三个问题。这正是理解这篇论文技术核心的关键。

1. 关联性 (Relatedness) vs. 组合性 (Compositionality) 的区别

简单来说,关联性是“静态”的,而组合性是“动态”的。

-

关联性 (Relatedness)

- 核心思想: 它将复合词(如

airport)和其成分(air和port)都看作是语义记忆中已经存在的、独立的单元。它衡量的是这些独立单元在语义空间中的**“距离”或“相似度”**。 - 打个比方: 在你的大脑知识网络中,“机场”这个概念和“空气”这个概念的联系有多紧密?它不关心“机场”这个词是如何被“创造”出来的,只关心它们现成的意义有多相关。

- 它回答的问题: “整个复合词的实际意义,与其各个成分的独立意义有多相似?”

- 核心思想: 它将复合词(如

-

组合性 (Compositionality)

- 核心思想: 它关注的是**“组合”这个动作本身**。它把成分看作是**“积木”**,并评估将这些积木搭建成复合词意义的过程有多么顺畅、高效和可预测。

- 打个比方: 它衡量的不是结果(“机场”的意义),而是过程:将“空气”和“港口”这两个意义通过一个特定的组合规则(即 CAOSS 模型)生成一个新意义的过程。修饰语组合性高,意味着“空气”这个积木很容易被放进组合过程里。

- 它回答的问题: “一个成分的意义对计算出的组合意义贡献有多大?”以及“通过这个组合过程计算出的意义,与复合词的实际意义有多接近(即可预测性有多高)?”

总结一下核心区别:

| 特性 | 关联性 (Relatedness) | 组合性 (Compositionality) |

|---|---|---|

| 视角 | 静态的、关联的 | 动态的、过程的 |

| 比较对象 | 实际词义 ↔ 成分词义 |

成分词义 → 计算出的词义 ↔ 实际词义 |

| 核心问题 | 意义的相似度 | 意义的构建与贡献 |

| 典型例子 | 即使 firework(烟花)和 fire(火)关联性很高,但它的组合性可能不高,因为你无法通过简单的“火+作品”精确推导出“烟花”的完整概念。 |

2. 两者是如何计算出来的?

两者都基于分布式语义向量 (distributional semantic vectors) 和余弦相似度 (cosine similarity)。

首先,模型从大型语料库中为每个词(如 Flughafen, Flug, Hafen)学习一个高维向量。向量代表了词的意义,两个向量之间的余弦相似度(范围-1到1)代表了它们的语义相似度。

-

关联性 (Relatedness) 的计算 (直接比较)

- 修饰语关联性 (Modifier Relatedness): 计算

修饰语向量与整个复合词向量之间的余弦相似度。cosine_similarity(vector("Flug"), vector("Flughafen"))

- 核心词关联性 (Head Relatedness): 计算

核心词向量与整个复合词向量之间的余弦相似度。cosine_similarity(vector("Hafen"), vector("Flughafen"))

- 成分相似性 (Constituent Similarity): 计算

修饰语向量与核心词向量之间的余弦相似度。cosine_similarity(vector("Flug"), vector("Hafen"))

- 修饰语关联性 (Modifier Relatedness): 计算

-

组合性 (Compositionality) 的计算 (间接比较,需要中间步骤)

组合性的计算多了一个关键步骤:先计算出一个理论上的“组合意义向量 c”。-

生成组合意义向量 (c):

使用 CAOSS 模型公式 c = Mu + Hv 来生成这个向量。其中 u 是修饰语向量,v 是核心词向量,M 和 H 是学习到的权重矩阵。这个 c 代表了模型“认为”这两个词组合后应该是什么意思。 -

计算组合性指标:

- 修饰语组合性 (Modifier Composition): 计算

修饰语向量 u与组合意义向量 c之间的余弦相似度。这衡量了修饰语对组合过程的贡献度。cosine_similarity(u, c)

- 核心词组合性 (Head Composition): 计算

核心词向量 v与组合意义向量 c之间的余弦相似度。cosine_similarity(v, c)

- 复合词组合性 (Compound Compositionality): 计算

组合意义向量 c与整个复合词的实际向量之间的余弦相似度。这衡量了复合词意义的可预测性。cosine_similarity(c, vector("Flughafen"))

- 修饰语组合性 (Modifier Composition): 计算

-

3. CAOSS 模型的权重 (M 和 H 矩阵) 是怎么学习的?

CAOSS 模型的权重矩阵 M 和 H 是通过一个基于回归的监督学习过程训练得到的。

-

准备大型训练数据:

研究人员收集了海量的(论文中提到超过 42,000 个)已知的德语复合词。对于每一个复合词,他们都有三样东西:- 修饰语的词向量 (u)

- 核心词的词向量 (v)

- 整个复合词的词向量 (w, 作为“正确答案”)

-

设定学习目标:

模型的目标是找到最优的权重矩阵 M 和 H,使得对于训练集中的所有复合词,通过公式M*u + H*v计算出的预测向量 c,与真实的复合词向量 w 之间的差距(误差)最小。 -

使用最小二乘回归 (Least-Square Regression):

这是一种标准的机器学习方法。模型会不断调整 M 和 H 矩阵中的数值,来最小化所有训练样本的“预测误差的平方和”。通过在数万个样本上进行这种优化,模型就能学到:- M 矩阵: 当一个词作为修饰语时,应该如何调整(旋转、缩放)它的语义向量,才能最好地融入组合意义。

- H 矩阵: 当一个词作为核心词时,应该如何调整它的语义向量。

-

应用与泛化:

一旦 M 和 H 矩阵被训练好,它们就固定下来了。这时,模型就可以被用来为任何新的、甚至从未见过的复合词(比如实验中用到的新造词)计算其组合意义向量 c,从而分析它们的组合性。

cosine_similarity (u, c) 和cosine_similarity (vector ("Flug"), vector ("Flughafen")) 有啥区别?不都是修饰语和整个字词向量的相似度吗?而且,为什么所有复合词的向量是一样的呢?这假定了所有复合词的组合模式都是一样的吗?

您提了两个非常深刻且关键的问题!它们正好揭示了这个模型最精妙也最容易混淆的地方。让我们逐一拆解。

问题一:cosine_similarity(u, c) 和 cosine_similarity(vector("Flug"), vector("Flughafen")) 的区别

您的观察非常敏锐:“不都是修饰语和整个字词向量的相似度吗?”

从表面看是的,但核心区别在于,它们比较的“整体词向量”是完全不同的东西:一个是真实的、已存在的词义,另一个是计算出的、理论上的词义。

1. cosine_similarity(vector("Flug"), vector("Flughafen")) -> 关联性 (Relatedness)

-

这里的

vector("Flughafen")是什么?

它是从大型文本语料库中直接学习到的、代表“Flughafen”这个词实际含义的向量。它反映了这个词在真实世界语言使用中的所有语义信息,包括它的功能、相关概念(飞机、旅行、塔台等)。它是一个已存在的、观测到的数据点。 -

这个计算衡量了什么?

它衡量的是两个独立的、已经存在的概念——“飞行”和“机场”——在语义空间中的距离有多近。这是一种静态的语义关联度。 -

它回答的问题是:

“在人们的普遍认知中,【飞行】这个概念和【机场】这个概念有多接近?” 它不关心“机场”这个词是怎么来的,只关心这两个概念本身的关系。

2. cosine_similarity(u, c) -> 修饰语组合性 (Modifier Composition)

-

这里的

c是什么?

这里的c不是vector("Flughafen")!它是通过 CAOSS 模型公式c = M·u + H·v计算出来的预测向量或组合意义向量。它代表了模型根据学到的组合规则,“认为”Flug(u) 和Hafen(v) 组合起来应该是什么意思。它是一个新生成的、理论上的数据点。 -

这个计算衡量了什么?

它衡量的是“飞行”(u)这个成分的意义,对那个由模型创造出来的组合意义(c)贡献了多少。这是一种动态的组合贡献度。 -

它回答的问题是:

“在我们构建‘飞行港口’这个新概念的过程中,‘飞行’这个成分起到了多大的塑造作用?” 如果u和c高度相似,说明修饰语的原始意义在组合过程中被很好地保留和利用了。

总结与类比

| 对比项 | 关联性 (Relatedness) | 组合性 (Compositionality) |

|---|---|---|

| 比较对象 | vector("Flug") ↔ vector("Flughafen") |

vector("Flug") ↔ c (预测向量) |

| 整体词向量 | 真实的、语料库中的词义 | 理论的、模型计算出的词义 |

| 测量维度 | 静态的概念相似度 | 动态的过程贡献度 |

| 好比 | 问:“盐”和“咸味薯片”的味道有多相关? | 问:在做薯片的过程中,“盐”这个原料对最终成品的咸味贡献了多少? |

问题二:为什么所有复合词的向量是一样的?这假定了所有复合词的组合模式都是一样的吗?

这是一个绝佳的问题,它引出了模型的另一个核心假设。首先,需要澄清一个关键点:

并非所有复合词的向量是一样的,而是用于组合它们的“转换规则”(权重矩阵M和H)是一样的。

- 每个独立的复合词,比如

Flughafen(机场) 和Baumhaus(树屋),在语义空间中都有自己独一无二的向量。 - 同样,每个成分,如

Flug,Hafen,Baum,Haus也有自己独特的向量。

那么,您问题的核心就变成了:

为什么所有复合词共享同一套 M 和 H 矩阵?

是的,这正是模型的关键假设:它假定了德语中名词-名词复合词的组合模式存在一种普遍的、可学习的语义规律。

-

M 和 H 是“语义语法规则”

您可以把 M 和 H 想象成一种语义层面上的“语法规则”。就像英语语法中,我们有一个通用的规则“给名词加-s变为复数”,这个规则可以应用到几乎所有名词上(cat->cats,dog->dogs)。这个“-s”规则是通用的,但它所应用的词(cat,dog)是独特的。同样,CAOSS 模型学习到的:

- M 矩阵:代表了“当一个词充当修饰语时,它的语义应该如何被调整”的通用规则。

- H 矩阵:代表了“当一个词充当核心词时,它的语义应该如何被调整”的通用规则。

-

普遍性与特殊性的结合

模型并没有假设Flughafen和Baumhaus的组合模式完全一样。组合过程的输入是完全不同的:Flughafen的输入是vector("Flug")和vector("Hafen")。Baumhaus的输入是vector("Baum")和vector("Haus")。

模型用同一套通用的组合规则(M 和 H)来处理这些完全不同的输入,从而得到不同的输出(预测向量 c)。

-

模型的学习目标

通过在数万个复合词上进行训练,模型的目标不是记住每个复合词的意思,而是提炼出这种通用的、抽象的组合规律。它学会了“修饰语通常会给核心词增加什么样的语义信息”以及“核心词的哪些语义特征在组合后会被保留或凸显”。

总结:该模型的设计巧妙之处在于,它在**普遍性(通用的组合规则 M 和 H)和特殊性(每个词独特的向量 u 和 v)**之间取得了平衡。它承认每个复合词都是独一无二的,但又试图捕捉它们背后共同的语言创造规律。